- soww

- Wstęp

-

1.

egzamin2015

- 1.1. Podaj zasadnicze różnice w zrównoleglaniu kodu na GPU i na klastrze maszyn z CPU

- 1.2. W jaki sposób można by w aplikacji MPI zrealizować funkcję signal

- 1.3. Podaj przykład ponadliniowego przyśpieszenia obliczeń i wyjaśnij możliwe przyczyny

- 1.4. Wyjaśnij działanie funkcji MPI_Cancel i MPI_Allgathery

- 1.5. Jak zainplementowałbyś dodawanie n wartości w n wątkach w OpenMP?

- 1.6. Mamy wiele zbiorów z liczbami naturalnymi. Jak stworzyć algorytm równoległy do znajdowania części wspólnych każdej pary zbiorów?

- 1.7. Co wpływa na szybkość aplikacji równoległych

- 1.8. Opisać MPI_Probe i MPI_Init_thread

- 1.9. Zaprojektuj algorytm, który w dużym pliku tekstowym znajdzie wszystkie występowania danych ciągów znaków (wzorców).

- 1.10. Hyper-threading

- 2. Co oznaczają przedrostki

- 3. W jakim celu stosujemy równoległe przetwarzanie na klastrach?

- 4. Paradygmaty programowania równoległego

- 5. Zapisywanie i wznawianie stanu działania

- 6. Prawo (Amdahla, Gustafsona + metamorfoza kierowcy)

-

7.

MPI

- 7.1. Wyjaśnij jak zaimplementować w kodzie procesu (C+MPI) odbieranie dowolnych wiadomości od procesów o rankach 2,3 i 8.

- 7.2. Wyjaśnij jak zaimplementować barierę pomiędzy procesami w MPI_COMM_WORLD za pomocą funkcji MPI_SEND oraz MPI_RECV.

- 7.3. MPI odebranie komunikatu o nieznanym rozmiarze

- 7.4. MPI_INIT_THREAD

- 7.5. MPI_IRECV

- 7.6. Jak się komunikować z procesem stworzonym przez MPI_COMM_SPAWN

- 7.7. Typy funkcji send w MPI

- 7.8. Nakładanie komunikacji z obliczeniami + przykład + pseudokod przykładu (MPI+C)

- 7.9. Wielowątkowość

- 7.10. MPI-2 I/O

- 7.11. Wyjaśnić co to jest "persistent communication" w MPI

- 7.12. Wyjaśnij różnice pomiędzy intra i interkomunikatorami w MPI oraz wyjaśnij w jakim kontekście wykorzystywane są te ostatnie w MPI-2.

- 7.13. Rodzaje sendów

- 7.14. Rodzaje waitów:

- 7.15. Funkcje zbierające i rozsyłające dane

- 7.16. Komunikacja nieblokująca (np. IRSEND) co to jest

- 7.17. Jak można zintegrować MPI i OpenMP? Czym różni się to od MPI thready z laboratorium?

- 7.18. Jak przyspieszyć start (wysyłanie danych) i zakończenia (odbieranie wyników) przy nakładaniu obliczeń i komunikacji? Jakich funkcji MPI użyć?

- 7.19. Funkcje

- 7.20. Tryby dostępu w MPI2:

- 8. Związek pomiędzy liczbą procesorów a speedupem + wykres przyspieszenia

- 9. Kiedy przyśpieszenie ponad liniowe/ super liniowe?

- 10. Parametry wydajnościowe w komunikacje klastrów

- 11. wzór na czas wykonania się programu wykonującego filtr obrazka

- 12. Zwiększenie niezawodności aplikacji równoległych

- 13. Jak zaimplementowac powiadamiane innego procesu w dowolnej aplikacji

-

14.

Zadania z kodem (pseudokodem)

- 14.1. Napisz kod OpenMP + MPI - suma 1/(1+1) + 1(2+2) + ...

- 14.2. Napisać kod aplikacji do wyszukiwania w pliku najdłuższego ciągu znaków ‘xxx’

- 14.3. (C, OpenMP, MPI) Napisz pseudokod programu, który wypisze na ekran liczby pierwsze bliźniacze z zadanego zakresu. [takie dwie liczby pierwsze, których różnica wynosi 2.]

- 14.4. Napisz kod programu równoległego z MPI (pseudokod C+MPI), który będzie wyszukiwał liczby pierwsze w zadanym przedziale (punktowana optymalizacja).

- 14.5. Jak sprawdzić jaki jest tag i source?

- 14.6. Napisz pseudokod programu równoległego (C + MPI + OpenMP), który znajduje liczby pierwsze w danym przedziale.

- 14.7. Podaj pseudokod (MPI+C) przynajmniej dwóch metod pozwalających na nakładanie obliczeń i komunikacji.

- 15. Wyjaśnić sposób implementacji stwierdzenia upadku węzła w PVM

- 16. Co to jest SID i RID i kiedy który z nich jest lepszy, a kiedy gorszy (w kontekście poziomu ogólnego obciążenia aplikacji)

- 17. Wyjaśnić sposób implementacji kolejki priorytetowej w MPI

- 18. Podaj jaką rolę odgrywają parametry sieci komunikacyjnej dla konkretnych paradygmatów aplikacji równoległych, dla jakich warto używać MPICH-G2 i dlaczego?

- 19. Metody synchronizacji przy migracji procesów

- 20. Zaproponuj sposób na równoległe i niezawodne sortowanie liczb przy założeniu, że jeden z węzłów może ulec awarii

- 21. Zaprojektuj architekturę aplikacji rozproszonej przetwarzającej obraz ze strumienia danych "przeszukującej strumień dźwięku w poszukiwaniu podejrzanych dźwięków".

- 22. Co znaczą: #pragma omp section #pragma omp master #pragma omp critical

- 23. Jakie są kluczowe parametry komunikacyjne? Podaj wartości dla znanych Ci sposobów komunikacji. Jakie to ma znaczenie w przetwarzaniu SIMD?

- 24. Jakie będzie przyspieszenie dla zrównoleglenia algorytmów: merge sort, buble sort, mnożenie macierzy i równoległe rozwiązywanie równań liniowych? Porównaj i opisz rozwiązanie.

- 25. Koszt działania algorytmów (sekwencyjnych i równoległych)

- 26. Problemy programowania współbieżnego

- 27. Zaimplementować rozproszoną obsługę sygnałów

- 28. Dzialanie funkcji pthread_cond_…

- 29. Opisz zjawisko wyścigów.

- 30. Narysuj typowy wykres przyspieszenia obliczeń względem liczby procesorów i wyjaśnij.

- 31. Nakładanie na siebie obliczeń i komunikacji - na czym polega.

- 32. Pytanie o technologie i narzedzia zrownoleglania programow.

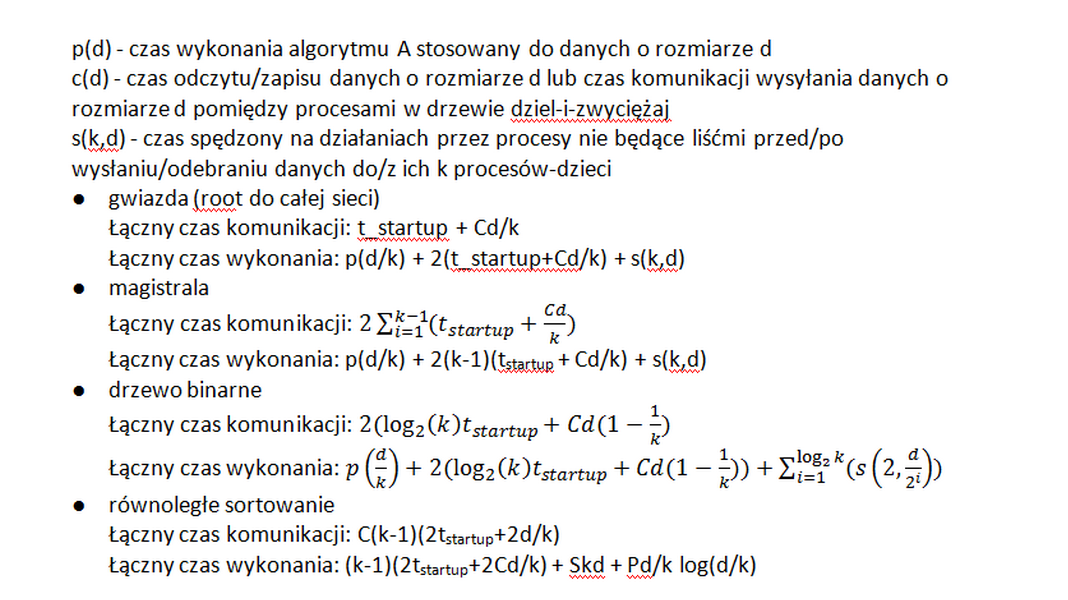

- 33. Czas wykonania SPMD.

- 34. Twój program działa wolniej niż myślałeś. Co robisz i dlaczego?

- 35. Opisz, jak wydajnie zrównoleglić nieregularny problem typu dziel i zwyciężaj.

- 36. Opisz, jak zrównoleglić aplikację, która symuluje powódź.

- 37. Jeśli wywołasz MPI_Send() i MPI_Recv w różnych wątkach procesu - czy zadziałają?

- 38. Zapisywanie i wznawianie stanu działania

- 39. Zaimplementować rozproszoną obsługę sygnałów

- 40. Ilu użyć procesorów? Jaka jest skalowalność aplikacji?

- 41. Jak sprawdzić ile jest używanych (= aktywnych) wątków w Open MP

- 42. Jak można wykorzystać wątki w MPI do nakładania obliczeń i komunikacji?

- 43. Twój program działa wolniej niż myślałeś. Co robisz i dlaczego?

- 44. Komunikacja z procesem stworzonym przez MPI_C0mm_Spawn()

- 45. Porównanie I/O MPI-1 i MPI-2